RAG

図解でわかる!RAGの仕組みと全体像

JAPANWAVE編集部2025年9月10日読了時間: 4分

.png&w=3840&q=75)

RAGの仕組みを図解で理解する

近年、生成AI(LLM)を活用したアプリケーションで注目されているのが RAG(Retrieval-Augmented Generation) という仕組みです。

RAGは、大規模言語モデル(LLM)に「外部知識」を組み合わせることで、より正確で信頼性の高い回答を生成できるようにする方法です。

今回は、その全体像をわかりやすく図解で整理しました。

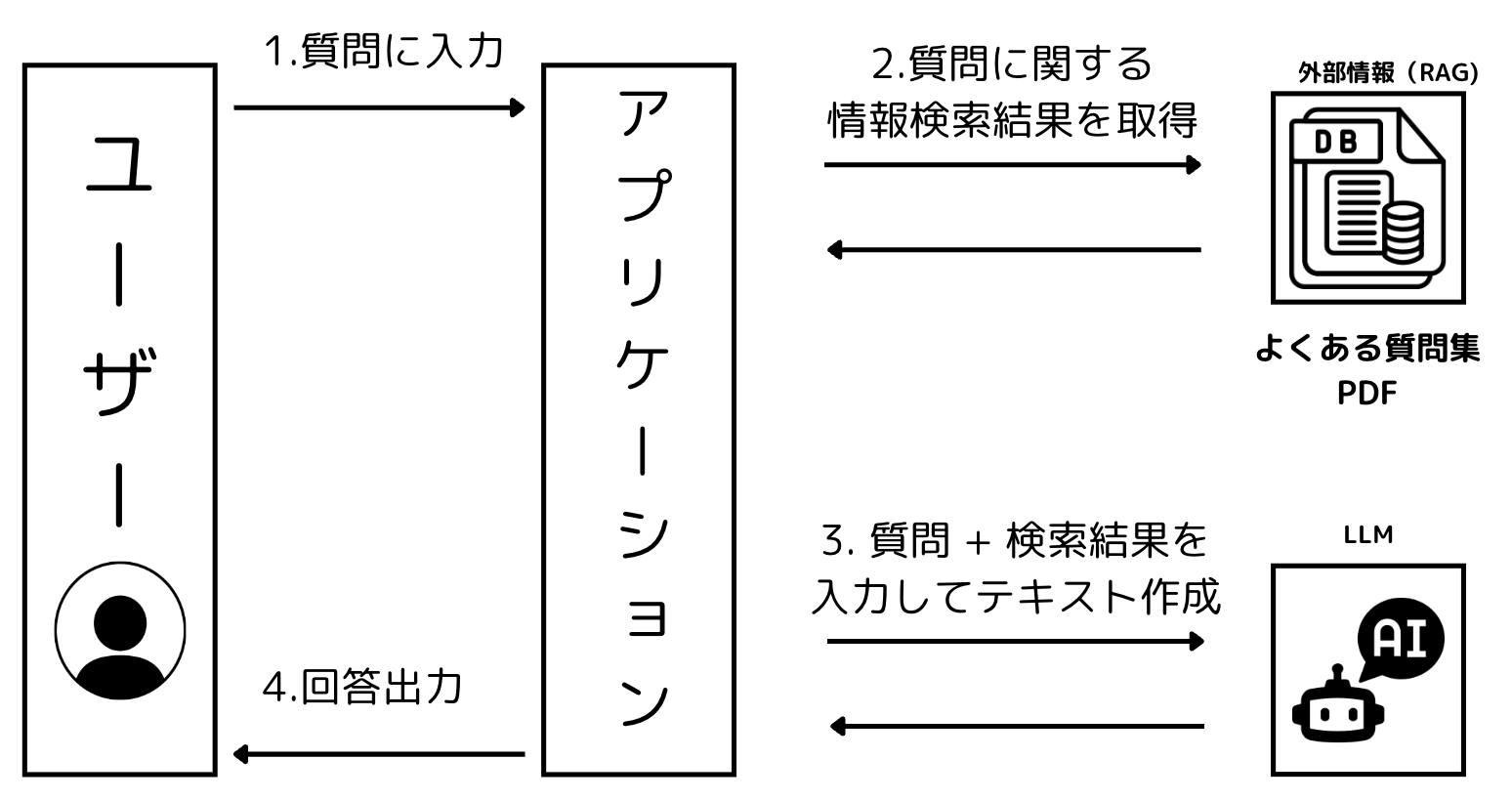

RAGの全体像

.png)

👤 ユーザー(画面中央左)

- チャットシステムを通じて質問やリクエストを送る存在。

- 例:「最新の経費精算ルールを教えてください」など。

💬 チャットシステム(画面中央真ん中)

- ユーザーとLLM(大規模言語モデル)をつなぐ役割を持つインターフェース。

- ユーザーの質問を受け取り、検索や回答生成の流れを制御する。

- 最終的に、LLMが生成した答えをユーザーに返す。

🧠 LLM(大規模言語モデル)(画面中央上)

- ユーザーの質問と、検索で取得した関連情報をもとに自然な回答を生成するAI。

- ChatGPT、Claude、Geminiなど、さまざまなモデルを利用可能。

📜 テキスト化されたデータ群(画面右上)

- 企業のマニュアル、FAQ、技術ドキュメント、ナレッジベースなど。

- RAGの基盤となる「外部知識」として格納される情報源。

- PDFやWord、Webページなどをテキスト化して利用。

🔗 Embeddingモデル(画面右下)

- テキストを数値ベクトルに変換(=ベクトル化)するAIモデル。

- 文章の「意味的な特徴」を数値で表すため、検索時に「キーワード一致」ではなく「意味の近さ」で関連情報を探せるようになる。

- 例:OpenAIの

text-embedding-3-small、Googleの Gemini Embedding など。

📊 ベクトルストア(画面真ん中下)

- ベクトル化されたテキストを保存・検索するデータベース。

- ユーザーの質問をベクトル化し、ここに照合して「意味的に近い文書」を見つけ出す。

- 代表的な技術:Pinecone、Weaviate、Milvus、Postgres(pgvector) など。

RAGを用いた処理フローの流れ

① 質問に入力

ユーザーがアプリケーションに質問を入力します。

例:「経費精算の手順を教えてください」

② 質問に関する情報検索結果を取得

アプリケーションは外部情報(RAG用のナレッジベース)から、質問に関連する情報を検索します。

- 例:よくある質問集やマニュアルPDFなどを参照

- Embeddingを利用して「意味的に近い文書」を取得

③ 質問 + 検索結果を入力してテキスト作成

アプリケーションは、ユーザーの質問と検索で得られた関連文書を LLM(大規模言語モデル)に渡します。

- LLMはその情報をもとに、自然で文脈に沿った回答を生成します。

④ 回答出力

アプリケーションがLLMの生成結果をユーザーに返します。

例:「経費精算は、領収書をシステムにアップロードし、承認者に提出してください」

なぜRAGが重要なのか?

LLMは強力ですが、学習済みデータに基づいて回答を生成するため、情報が古かったり不正確なことがあります。

RAGを導入することで以下のメリットがあります。

- 最新の情報を参照可能(マニュアルやドキュメントを取り込み可能)

- 正確性の向上(事実に基づいた回答ができる)

- 社内専用の知識活用(独自データを組み込んだチャットボットの構築が可能)

まとめ

RAGは「LLM × 外部知識検索」の組み合わせであり、生成AIを業務やサービスに活かす上で欠かせない技術です。

今後、RAGを使った社内チャットボットやFAQシステムはますます広がっていくでしょう。

※ 本記事の内容は、執筆時点での情報に基づいています。最新の情報と異なる場合がございますので、あらかじめご了承ください。 また、記載されている内容は一般的な情報提供を目的としており、特定の状況に対する専門的なアドバイスではありません。 ご利用にあたっては、必要に応じて専門家にご相談ください。